![[*]](crossref.png) ) e considerando

l'insieme complemento di

) e considerando

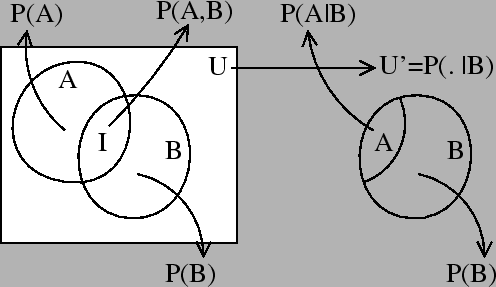

l'insieme complemento di Prima di iniziare a discutere dei modelli di Markov nascosti o Hidden Markov Models (HMM), richiameremo alcuni utili concetti relativi alla calcolo delle probabilità.

Se definiamo con ![]() la probabilità che avvenga l'evento

la probabilità che avvenga l'evento ![]() e con

e con ![]() (universo) l'insieme di tutti i possibili eventi, si ha che

la probabilità dell'evento

(universo) l'insieme di tutti i possibili eventi, si ha che

la probabilità dell'evento ![]() (scritta

(scritta ![]() ) la possiamo definire come la misura

dell'insieme

) la possiamo definire come la misura

dell'insieme ![]() diviso la misura dell'insieme universo

diviso la misura dell'insieme universo ![]() . Detto in altro

modo la probabilità la definiamo come il numero di possibilità in cui

l'evento

. Detto in altro

modo la probabilità la definiamo come il numero di possibilità in cui

l'evento ![]() sia verificato diviso per il numero complessivo di tutte

le possibilità che consideriamo (il nostro insieme universo

sia verificato diviso per il numero complessivo di tutte

le possibilità che consideriamo (il nostro insieme universo ![]() ).

Nel caso di variabili continue consideremo l'integrazione sull'intervallo della funzione di

densità di probabilità.

Utilizzando la notazione insiemistica (Figura

).

Nel caso di variabili continue consideremo l'integrazione sull'intervallo della funzione di

densità di probabilità.

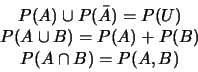

Utilizzando la notazione insiemistica (Figura ![[*]](crossref.png) ) e considerando

l'insieme complemento di

) e considerando

l'insieme complemento di ![]() come

come ![]() possiamo verificare le seguenti

equazioni

possiamo verificare le seguenti

equazioni

![[*]](crossref.png) .

In pratica siccome

.

In pratica siccome

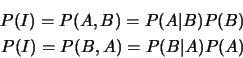

Di particolare interesse è il caso di eventi indipendenti.

Quando abbiamo a che fare con eventi indipendenti, o assumiamo che siano tali

per semplificarci la vita, otteniamo anche una semplificazione della

probabilità congiunta di tale serie di eventi.

In particolare se ![]() non dipende da

non dipende da ![]() allora abbiamo che

allora abbiamo che ![]() .

Nel caso generale, se consideriamo la probabilità del verificarsi degli

.

Nel caso generale, se consideriamo la probabilità del verificarsi degli

![]() eventi congiunti

eventi congiunti

![]() abbiamo

abbiamo

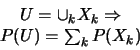

Possiamo poi immaginare di frammentare l'insieme ![]() in sottoinsiemi tali

per cui la loro unione genera esattamente l'insieme

in sottoinsiemi tali

per cui la loro unione genera esattamente l'insieme ![]() stesso. In questo

modo possiamo generare più partizioni diverse la cui unione dia origine

sempre all'insieme

stesso. In questo

modo possiamo generare più partizioni diverse la cui unione dia origine

sempre all'insieme ![]() . Per esempio se l'insieme

. Per esempio se l'insieme ![]() è dato dai sei possibili

valori (1,2,3,4,5,6) posti sulle facce di un dado, allora due possibili partizioni

sono:

è dato dai sei possibili

valori (1,2,3,4,5,6) posti sulle facce di un dado, allora due possibili partizioni

sono: ![]() ={dispari}

={dispari}![]() {pari} e

{pari} e ![]() ={1,3}

={1,3}![]() {2,4}

{2,4}![]() {5,6}.

Data una partizione la cui unione generi l'insieme

{5,6}.

Data una partizione la cui unione generi l'insieme ![]() (

(

![]() ), possiamo scrivere

la probabilità di

), possiamo scrivere

la probabilità di ![]() come somma delle probabilità che si verifichi

l'evento

come somma delle probabilità che si verifichi

l'evento ![]() in concomitanza con ciascuno degli eventi la cui unione genera l'insieme

in concomitanza con ciascuno degli eventi la cui unione genera l'insieme ![]() .

Esprimendo il tutto in maniera più formale abbiamo

.

Esprimendo il tutto in maniera più formale abbiamo

|